СОДЕРЖАНИЕ

Базовые принципы анализа сайта

Использование штатных вебмастер-сервисов от поисковых систем

Сервисы для онлайн-анализа сайта

Итак, вот мы, наконец-то, и добрались до подготовки статьи по анализу сайта. Анализ сайта представляет собой ряд процедур, направленных на поиск каких-либо крупных ошибок (базовый анализ), оценку технического состояния сайта (т.е. технический анализ), состояния в поисковой выдаче (SEO-анализ), а также оценки комфорта сайта (юзабилити-анализ).

При этом крайне важно, чтобы любую из этих трех оценок проводил именно независимый эксперт.

В данной статье речь пойдет о SEO- и техническом анализе сайта.

Зачем нужен SEO-анализ сайта

Для начала стоит отметить, что данный анализ проводится с двух сторон:

- со стороны специалиста по поисковой оптимизации;

- со стороны поисковой системы.

На втором пункте остановимся немного поподробнее.

У каждой поисковой системы есть свои фильтры, попав под которые сайт может вылететь из поисковой выдачи либо частично, либо полностью. В вебмастер-кабинетах от Google и Яндекса можно выяснить, под каким именно фильтром находится сайт, что именно не нравится поисковой системе, а также, составить план мероприятий по выведению сайта из-под фильтра.

SEO-анализ необходим каждому, у которого имеется свой собственный сайт и кто заинтересован в его продвижении. И вот тут людей можно условно подразделить на 2 вида:

- те самые независимые эксперты (как правило, это и есть оптимизаторы), которые с каждым днем наращивают свою базу знаний, осваивают все новые и новые инструменты, оттачивают свои оптимизаторские способности, необходимые для тщательного анализа, т.к. они крайне заинтересованы в хорошем результате, чтобы клиент был доволен;

- те, для кого продвижение является средством рекламы своей деятельности, а в качестве бонуса – средством увеличения продаж.

Последним анализ сайта необходим как раз для того, чтобы убедиться в качестве выполненных работ и, следовательно, в положительной динамике.

Проводить анализ сайта можно по тому же чек-листу, по которому ранее проводилась оптимизация, однако, для этого потребуется вспомнить все работы по оптимизации, которые проводились с сайтом.

Что входит в анализ сайта?

Анализ сайта, в основном, имеет смысл проводить в двух случаях (их больше, но основных – два):

- до проведения работ по оптимизации – в этом случае рассматриваются основные ключевые моменты, требующие переориентирования, доработок или исправлений;

- после проведения работ по оптимизации – в этом случае упор делается на контроль качества проведенных работ, а также на то, какой эффект от них получен.

В первом случае производится оценка основных факторов, которые оцениваются поисковыми роботами. Необходимо выяснить, насколько быстро можно исправить те или иные ошибки, сколько сил и денег это отнимет у заказчика. Иногда бывает даже так, что вносить изменения на имеющемся сайте вообще нет смысла, т.к. добиться нужного уровня оптимизации либо является очень затруднительным, либо не представляется возможным. В этом случае самым правильным решением будет построение нового сайта на другом движке.

Во втором случае же проверяется качество ранее выполненной оптимизации сайта. В ходе анализа проверяется качество текстов, отвечают ли они на нужные поисковые запросы, нет ли там переспама, сопровождаются ли тексты картинками/списками/графиками/фотографиями/видеоматериалами, имеются ли на сайте кириллические УРЛы, внутренняя перелинковка между страницами сайта и т.д. Проверяются также и внешние факторы – количество ссылок, ведущих на Ваш сайт, их качество, и т.д. И самое главное – анализ выявленных ошибок – насколько сложно их исправить, а главное – стоит ли это вообще делать.

Допустим, что Ваш сайт полностью удовлетворяет основным требованиям поисковых систем и, соответственно, занимает вкусные позиции в поисковой выдаче. Однако, человекопонятные урлы (ЧПУ) выполнены в виде транслитерации, а не в виде кириллицы (т.е. https:/site.xyz/kak-pravilno-britsia вместо https:/site.xyz/как-правильно-бриться). На то могут быть различные причины – Ваше личное желание, или слишком большой бюджет на реализацию кириллических ЧПУ. Да, можно оставить ЧПУ и в транстил-формате, ибо контент всегда был и будет самой важной составляющей сайта, однако:

- если нет возможности (или желания) переделать транслит-ЧПУ в кириллические, то нужно сконцентрироваться на чем-то другом;

- если все-таки есть возможность быстро и безболезненно настроить переделать транслит-ЧПУ в кириллические, то эту возможность упускать не стоит.

Базовые принципы анализа сайта

Основные принципы, которыми следует руководствоваться при анализе сайта:

- самое первое, что нужно анализировать – стратегия сайта, ибо именно от нее зависит то, как будет реализовываться функционал сайта в дальнейшем;

- в ходе анализа необходимо располагать рекомендации по убыванию критичности, т.е. сначала идут самые критичные, потом менее критичные, а в самом конце списка должны располагаться рекомендации, которым следовать желательно, но не обязательно.

Теперь пару слов о том, насколько важно анализировать стратегию.

Что важно для СМИ, блога, сайта-статейника? Правильно – удобство использования и качество контента (особенно глубина его проработки). Очевидно, что если сайт будет неудобным, то и поведенческие факторы будут негативными, и исправить ситуацию контентом (даже если он ультракачественный) вряд ли получится. И наоборот – если качество контента на сайте оставляет желать лучшего – удобство сайта не спасёт ситуацию. Особенно это касается тех сайтов, где автор не может сказать по теме ничего нового. Шансы на успешное продвижение в этом случае есть, но очень небольшие, особенно если речь идет о долгосрочной перспективе.

Что важно для интернет-магазина? Правильно – богатый ассортимент товаров, сайт должен быть комфортным в использовании, а коммерческие факторы должны быть хорошо «прокачаны». НО… Что делать, если команда интернет-магазина не желает расширять ассортимент (например, не готова работать с новыми категориями товаров)? Что делать, если у команды интернет-магазина нет возможности (например, финансовой) улучшить юзабилити сайта? Ответ прост – быть готовым к тому, что упор на остальных факторах не даст мощного эффекта.

Если сама стратегия продвижения сайта (особенно в области SEO) выбрана неправильно, либо отсутствует возможность/желание реализовать верную стратегию, то никакое шаманство, никакие святые отцы, никакие пляски с бубном, никакие корректировки Title, Description, H1 и уж тем более KeyWords, никакая закупка ссылок, никакая корректировка ссылочной массы в пользу анкорных/безанкорных ссылок особо не помогут.

Итак, будем считать, что со стратегией мы разобрались.

Теперь рассмотрим несколько инструментов, с помощью которых можно провести анализ сайта и даже получить ряд рекомендаций по его развитию.

Технический анализ сайта

Ниже мы привели 3 группы инструментов, с помощью которых можно найти ошибки, которые существенно влияют на ранжирование сайта:

- штатные средства поисковых систем (например, вебмастер-кабинеты от Google и Яндекса);

- средства аналитики, предоставляемые теми же поисковыми системами;

- специальные сервисы аналитики – они как раз и созданы для того, чтоб осуществлять связь между поисковыми системами и владельцами сайтов.

Каждая из этих трех групп будет рассмотрена в отдельности, причем в порядке уменьшения ценности информации.

Существуют специальные сервисы, цель которых - в автоматическом режиме помогать сделать часть важнейших работ, необходимых для технического анализа сайта. Эти сервисы изучают Ваш сайт с помощью своих собственных «пауков», т.е. своими средствами.

Какую информацию может предоставить такой анализ:

- дублирующиеся или отсутствующие Title;

- наличие H1-заголовков;

- какие страницы закрыты от индексирования (либо через мета-тег noindex, либо через robots.txt);

- онлайн-проверка на наличие вредоносного кода (вирусов);

- проверка на то, находится ли сайт под фильтрами (о которых упоминалось в самом начале).

Начнем с сервиса SerpStat (https://serpstat.com/ru/).

Технический анализ с помощью сервиса SerpStat

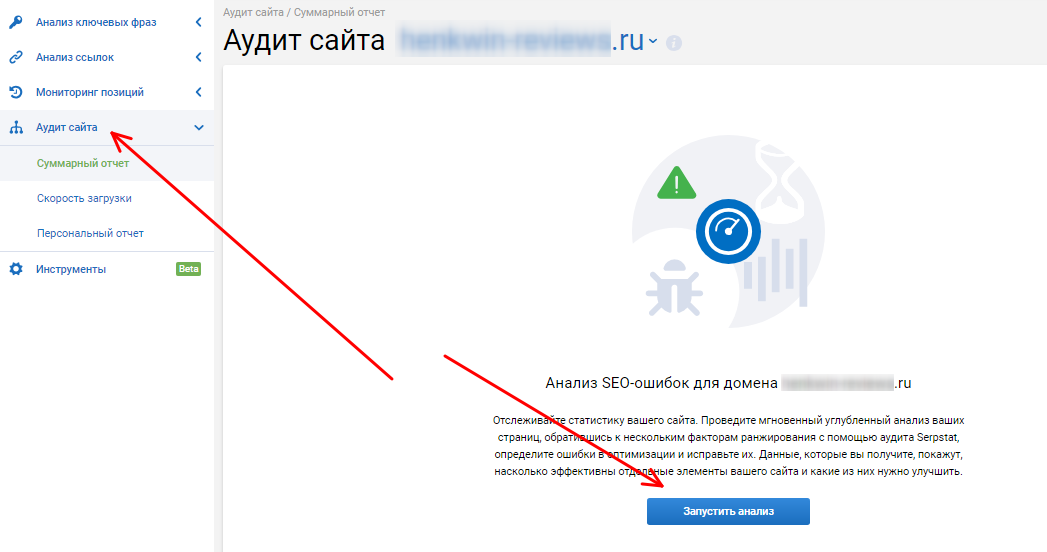

Самым первым делом необходимо имя Вашего домена добавить в список проектов, а далее задать настройки аудита. Затем в левом столбце выбираете «Аудит сайта» и нажимаете «Запустить анализ».

После этого у Вас появится окошко, в котором потребуется указать некоторые настройки. При желании можно указать количество страниц, которые сервис просканирует. По умолчанию устанавливается 100 страниц. Однако, технические неисправности могут быть где угодно, поэтому их количество можно увеличить. Также можно настроить скорость сканирования. Чем больше страниц – тем меньше должна быть скорость, чтобы не перегружать сервер, на котором расположен сайт.

В дополнительных настройках можно указать, стоит ли сервису учитывать поддомены сайта и рекомендации, указанные в файле robots.txt. Там же можно указать юзер-агента, «от имени которого» придет робот.

Еще раз нажимаем «Начать анализ» и ждем его окончания.

По окончании анализа сервис предоставит Вам список найденных на сайте ошибок, причем они будут проранжированы по убыванию степени важности, т.е. самые критические будут в самом начале. Однако, не стоит соглашаться с сервисом на все 100%. Например, избыточно длинные Title вполне могут быть отнесены ко второму (или даже к первому) приоритету, хотя гораздо правильнее дать данной ошибке третий. Но это уже мелочи.

Итак, с помощью данного сервиса можно выявить следующие ошибки:

- коды ответа сервера 4xx и 5xx серий;

- страницы, на которых отсутствует мета-тег Description (либо присутствует, но пустой);

- H1 совпадает с Title;

- отсутствует Title/H1;

- повторяющиеся Title (если один и тот же Title на сайте повторяется несколько раз, то страница вообще не будет ранжироваться, т.к. будет учтена как «дубль»);

- повторяющиеся Description;

- слишком короткие/длинные Description;

- слишком короткие/длинные Title;

- многократное использование Title/H1 на одной и той же странице;

- отсутствует информация о кодировке сайта;

- нарушена очередность H-заголовков;

- наличие страниц с Lorem ipsum (бессмысленным текстовым блоком, который вставляется на каждую страницу);

- отсутствует текст между <body> и </body>;

- слишком большой размер страницы;

- количество проиндексированных страниц;

- страницы, на которых тег rel=canonical используется больше одного раза;

- страницы, закрытые от индексации с помощью тега noindex;

- страницы со слишком маленькими текстами;

- страницы, на которых есть тег iframe;

- страницы с flash-элементами;

- canonical-ссылки ведут на сторонние домены;

- страницы, закрытые от индексирования через robots.txt;

- в теге canonical указана не та страница;

- страницы с редиректами;

- наличие фавиконки на сайте;

- слишком длинные адреса страниц;

- слишком много get-параметров в ссылках;

- слишком много исходящих ссылок на странице;

- редиректы с www.site.xyz на site.xyz;

- редирект с http- на https-версию сайта;

- страницы, где «по-старинке» ссылки ведут на http-версию сайта (даже если потом происходит редирект на https-версию);

- наличие незащищенных элементов;

- наличие http-страниц в sitemap.xml;

- используется ли технология Google AMP.

Как видите, сервис предоставляет достаточно много полезной информации, причем бесплатно. Однако, это далеко не весь бесплатный функционал сервиса.

Использование штатных вебмастер-сервисов от поисковых систем

Итак, SerpStat мы уже рассмотрели (справедливости ради стоит отметить, что аналогичных сервисов во Всемирной паутине предостаточно). Теперь переходим к рассмотрению вебмастер-кабинетов самих поисковых систем. Называются эти кабинеты Google Search Console и Яндекс.ВебМастер.

С их помощью можно «выловить» следующие моменты:

- наличие фильтров, наложенных поисковыми системами в автоматическом режиме;

- наличие фильтров, наложенных представителями поисковых систем вручную;

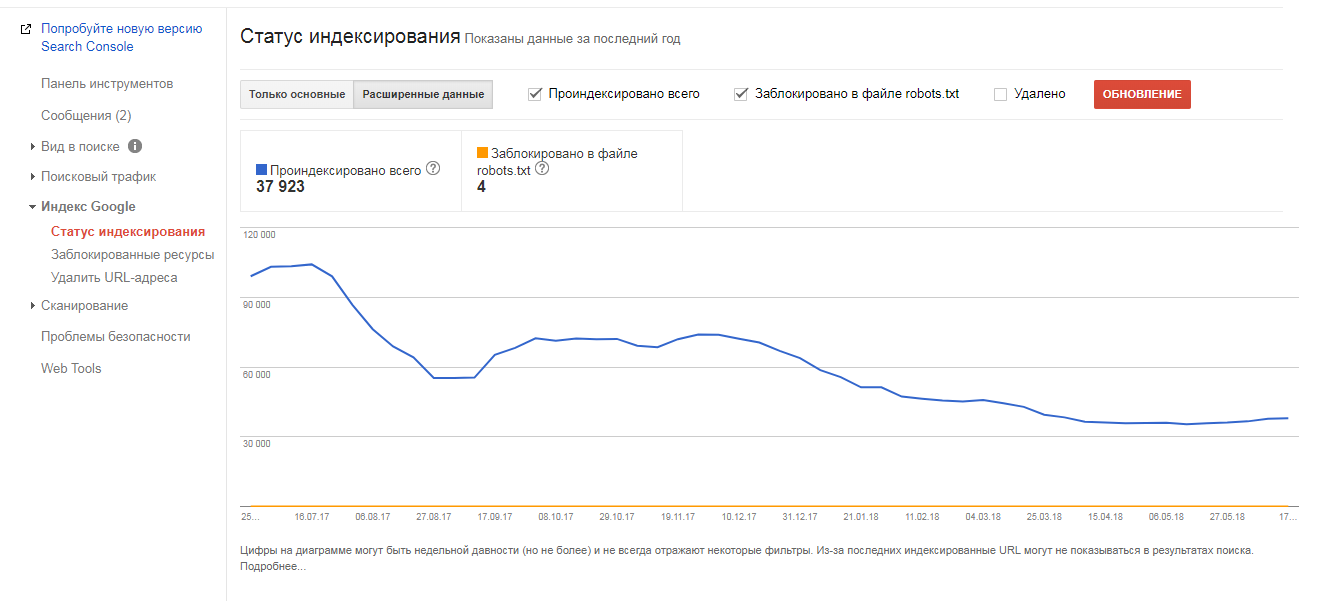

- сколько страниц выпало из индекса;

- причины выпадения страниц из индекса;

- были ли массовые ошибки 3xx, 4xx или 5xx серий;

- имеются ли фильтры от роботов поисковиков;

- сканирование сайта на предмет вирусов;

- какие параметры УРЛ поисковые системы считают пагинацией, а какие – сортировкой и отображением.

Отдельное слово про фильтры. Некоторые из них (как автоматические, так и ручные) вполне реально продиагностировать «снаружи», т.е. с использованием сторонних сервисов. Однако, часть фильтров можно диагностировать путем сравнения «было-стало» видимости сайта в поисковой выдаче, позиций сайта по ряду поисковых запросов, а также путем выявления других мелочей (например, обнуление тИЦ). Если наблюдается что-то подобное, то заходим в вебмастер-кабинеты и ищем информацию о том, под какие фильтры попал сайт.

Крайне полезным будет отслеживание соотношения числа проиндексированных страниц и числа страниц, которые посетил краулер: это позволяет своевременно выявить причины слива (т.е. очень нерационального расхода) краулингового бюджета.

Также в вебмастер-кабинетах можно отслеживать, что происходило ранее. Например, сейчас в техническом отношении все нормально (т.е. на момент составления аудита), однако, позиции оставляют желать лучшего. И что делать? Как выяснить, в чем причина? Не исключено, что до аудита было устранено множество технических ошибок, а потом владелец сайта спохватился и к моменту аудита всё исправил. Следовательно, причины плачевных позиций экспертам, делающим аудит сайта, неясны. Именно в таких случаях и приходит на помощь ранее упомянутое отслеживание, с помощью которого можно ретроспективно увидеть всю необходимую техническую ситуацию, следовательно, оперативно разобраться в причинах.

Так же в вебмастер-кабинетах можно увидеть, как именно откликается сайт на посещение роботами поисковых систем. Это крайне важно, поскольку бывают ситуации, когда сайт прекрасно доступен всем пользователям, но при этом отказывается работать с поисковыми роботами. Вэбмастер-кабинеты – одно из немногих мест, где можно узнать об этой ситуации. С чем же это может быть связано?

Простейший пример - админы сайта при разработке вполне могут запретить роботам посещать сайт, а потом, когда сайт полностью готов, забывают снять запрет на посещение. Ситуация курьезная, но, отнюдь, не редкая.

Ну и плюс можно также в веб-мастерских увидеть информацию о вирусах или ином вредоносном коде, находящемся на сайте страниц. Да, сайт можно много где просканировать на вирусы, но сканирование в веб-мастерских если и не поможет, то как минимум не повредит.

Самостоятельный анализ сайта

Анализ сайта можно провести и самостоятельно. Все что требуется – сопоставить факторы, о которых рассказывается в этой статье со всеми имеющимися данными по Вашему сайту.

Ранее мы уже говорили, что сайт анализируется с точки зрения того, соответствуют ли те или иные факторы требованиям поисковых систем и их роботов, или не соответствуют. К слову – нередки конфликты между дизайнерами и оптимизаторами сайта. Почти во всех случаях это связано с тем, что дизайнеры не хотят рушить красоту сайта ради того, чтобы внедрить пару-тройку фишек, которые предлагают оптимизаторы (ну или переделать). Если такие конфликты и возникают, то решать их нужно так, чтобы это было не в ущерб продвижению, т.е. всегда можно найти компромисс. Плюс к этому, приоритет всегда должен быть у оптимизации, т.к. именно ее «из двух зол» поисковые системы и выбирают. Во Всемирной паутине полно примеров, когда не очень красивые, но оптимизированные сайты имеют гораздо более вкусные позиции, чем очень красивые, но слабо оптимизированные.

Сервисы для онлайн-анализа сайта

Итак, переходим к рассмотрению онлайн-сервисов по анализу сайта. Google Search Console и Яндекс.Вебмастер по умолчанию являются самыми оптимальными вариантами, поскольку позволяют не просто получить всю необходимую информацию по сайту, а получить ее от первоисточника, т.е. без «посредников». Именно поэтому в данной статье мы их рассматривать не будем.

Для того чтобы воспользоваться сервисами Google Search Console и Яндекс.Вебмастер, Вам потребуется:

- учетные записи в соответствующих поисковых системах;

- добавить УРЛ Вашего сайта в сам сервис поисковой системы;

- подтвердить Ваши права на сайт (несколько способов).

Самый простой способ подтвердить права на сайт – создать в корневом каталоге текстовый документ с определенным именем (поисковые системы скажут с каким), а затем запустить проверку наличия этого документа в каталоге сайта. Если проверка наличия данного файла будет успешно пройдена – права на сайт будут закреплены за Вами.

Все эти процедуры являются обязательными. Во-первых, таким образом, Вы получаете доступ к ряду полезных инструментов. Во-вторых, само по себе добавление сайта в кабинет делает его видимым для поисковых систем. Следовательно, ускоряется индексирование. Многим людям, которые слабо ориентируются в вопросах продвижения в поисковых системах, данные нюансы, увы, даже не известны.

1PS.ru

В сервисе 1PS.ru можно заказать:

- SEO-аудит;

- юзабилити-аудит;

- проверка сайта на ошибки;

- аудит текстов;

- аудит рекламы;

- аудит SMM;

- аудит SERM

и многое другое.

На выходе Вы получите подробный отчёт о найденных ошибках, а также чёткие рекомендации по их устранению, а в качестве бонуса - готовые технические задания по доработке сайта программистами и веб-мастерами.

Также можно заказать экспресс-анализ Вашего сайта, указав основные интересующие параметры и перечислив главные проблемы сайта.

Услуги платные, заявка оформляется через форму на сайте.

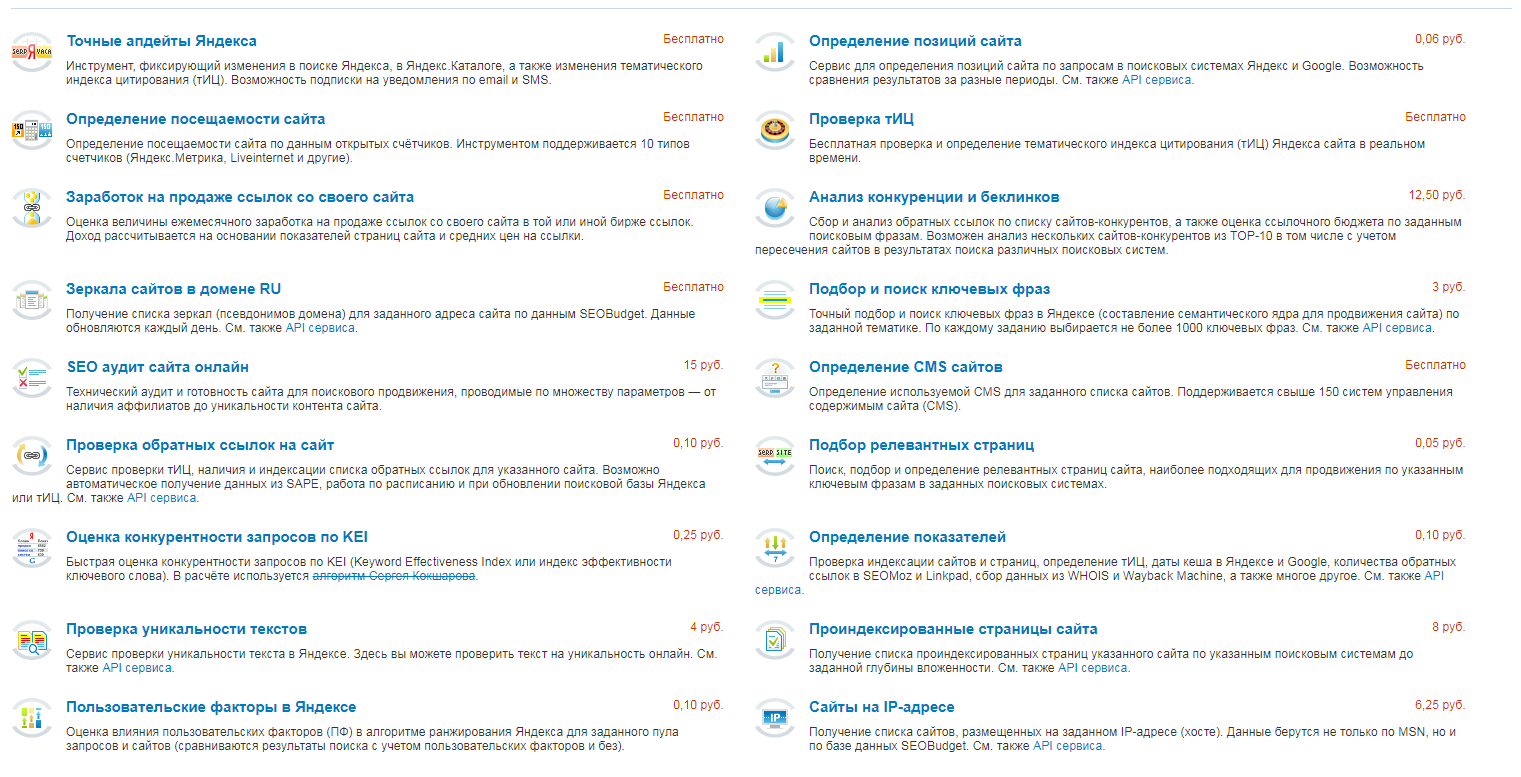

SEOBudget!

Данный сервис предлагает достаточно большое количество инструментов (https://seobudget.ru/tools/) для проведения самостоятельного анализа Вашего сайта:

- SEO-аудит;

- проверка текстов на уникальность;

- проверка тИЦ;

- сбор семантического ядра (списка ключевых фраз для дальнейшего продвижения);

- анализ ссылочной массы;

и многое другое. Часть инструментов бесплатные, часть – платные. Полный список сервисов, а также цены на платные сервисы Вы можете просмотреть, пройдя по указанной выше ссылке.

Но отдельного внимания заслуживает сервис по анализу позиций. Основная фишка в том, что Вы вводите УРЛ сайта, список продвигаемых ключей, а затем задаёте периодичность съема позиций (ежедневно, после каждого апдейта, еженедельно, ежемесячно, и т.д.).

Seoto.me

На сайте Seoto.me можно заказать проведение анализа Вашего сайта на наличие ошибок (для этих целей это один из лучших сервисов). Абсолютно весь процесс анализа сайта автоматизирован, а результат можно получить «на месте, не отходя от кассы». Услуга платная - вы пополняете счёт, указываете в соответствующей форме адрес Вашего сайта, нажимаете на кнопочку «сделай мне хорошо» и через некоторое время получаете результат. Кстати, эти же люди и разработали сервис СеоБюджет, о котором рассказано чуть выше.

Отчет об ошибках на выходе получается крайне подробным – проверяются даже тексты на сайте на предмет орфографии. Помимо этого, в отчете также содержится информация о:

- дублях страниц (если они есть);

- длинные/короткие Title/Description;

- мета-тегах, которые не релевантны своей странице;

- неработающие страницы;

и т.д.

Xtool

На нашем сайте данный сервис уже упоминался (мы тогда рассказывали о том, как проверить траст сайта). Кто не в теме, «траст» - это своего рода уровень уважения к сайту со стороны поисковых систем.

Помимо уровня траста сайта, сервис выдает еще и:

- историю изменений траста;

- историю изменений тИЦ и PR;

- индексацию в Яндексе;

- обратные ссылки;

- посещаемость;

- видимость в Яндексе и в Google;

- уровень раскрученности в Яндексе и в Google;

- данные Whois;

многое другое.

Из ультраважных плюшек:

- оценивается трафик на сайт;

- оцениваются внешние ссылки;

- проверка на попадание под фильтры;

- оценка рисков попадания под фильтры.

Т.е. сервис предоставляет достаточно широкий диапазон данных по Вашему сайту. И самое приятное – всё выше перечисленное предоставляется бесплатно.

PR-CY

Сервис http://pr-cy.ru/ также является одним из мощнейших (среди бесплатных) анализаторов сайтов. С его помощью можно буквально за минуту-две получить достаточно исчерпывающий отчет, а также заказать расширенный аудит.

В бесплатном режиме предоставляются данные:

- Яндекс тИЦ;

- Яндекс Rank;

- индексация в Яндекс и Google;

- наличие в Яндекс.Каталоге;

- наличие санкций (фильтров) со стороны поисковых систем;

- информация о наличии вредоносного кода на страницах;

- информация по трафику;

- информация по ссылкам на сайт;

- шаринг в социальных сетях;

- анализ контента;

- анализ скорости загрузки страницы;

- ошибки HTML-кода и JS;

- информация по кодам ответа;

- наличие адаптивной вёрстки

и еще много полезной информации. Да, всё «в общих чертах», но для того, чтобы понять, проблемный сайт или нет – большего и не требуется.

SpyWords

SpyWords — это платный (но очень мощный) сервис по подбору и анализу ключевых слов. Очень пригодится при составлении семантического ядра сайта.

С помощью данного сервиса можно узнать крайне много полезной информации о Ваших конкурентах:

- по каким ключам они продвигаются;

- по каким ключам они уже есть в поисковой выдаче;

- сколько посетителей получают с каждого ключевого слова;

- список ключевых слов, по которым ведется рекламная кампания (речь о контекстной рекламе).

Располагая данной информацией, Вы гарантированно получите высококачественное семантическое ядро, которое (при правильном продвижении) гарантированно даст много трафика.

Отдельного внимания удостаивается сервис «Умный подбор запросов». Просто указываете одно-два ключевых слова, а взамен получаете кучу реально работающих поисковых запросов (т.е. запросы, по которым дают рекламу, следовательно, по которым есть реальные переходы и, следовательно, заказы). А в таблице помимо запросов выводятся еще и:

- частота показов в Яндексе;

- Yandex CPC (cost per click), т.е. процент переходов;

- количество рекламодателей;

- схожесть фраз (в процентах).

Т.е. информация крайне исчерпывающая.

Alexa

Alexa (https://www.alexa.com/topsites/countries/RU) является представителем буржуйнета, ибо является англоязычным сервисом анатилики. Данный сервис с помощью собственных браузер-тулбаров собирает статистику использования сайтов. Больше подходит для анализа буржуйских сайтов, нежели для анализа сайтов Рунета.

«За бесплатно» полезной информации будет очень немного, чего нельзя сказать о платных отчетах. К слову – платные тарифы начинаются от 150$, т.е. по курсу на сегодня это около 9500 рублей, что для простого русского человека многовато.

Перечислять сервисы можно бесконечно. Сюда же можно было бы «впихнуть» такие сервисы, как ТопВизор, МегаИндекс, LinkPad и многие другие. Однако, статья и без них получилась, мягко говоря, не маленькая, поэтому расширять ее другими сервисами не будем.